Los «vacíos de datos» permiten que el contenido ofensivo aparezca en la parte superior de los resultados de búsqueda.

Los memes antisemitas que aparecen en los resultados de búsqueda de imágenes de Google llamaron la atención de los profesionales de la búsqueda la semana pasada, y de los medios más amplios esta semana. Muchos están instando a la empresa a realizar movimientos tangibles para eliminar dicho contenido.

Google no es el único motor de búsqueda que muestra estos odiosos memes: la editora en jefe de El Blog informatico, Ginny Marvin, señaló que también pueden ser encontrado en Bing y DuckDuckGo.

A primera vista, el problema puede parecer fácil de resolver simplemente eliminando el contenido ofensivo del índice; sin embargo, dicen ellos y otros, no es tan fácil y abre la puerta a decisiones más amplias sobre la moderación del contenido. El hecho de que Google no tenga planes definitivos para eliminar las imágenes ofensivas habla de cómo están diseñados para funcionar los motores de búsqueda.

Cómo han respondido (no) los motores de búsqueda

En una declaración a El Blog informatico, un portavoz de Google dijo:

“Entendemos que estos son resultados perturbadores y compartimos la preocupación por este contenido. No refleja nuestras opiniones. Cuando las personas buscan imágenes en Google, nuestros sistemas se basan en gran medida en hacer coincidir las palabras de su consulta con las palabras que aparecen junto a las imágenes en la página web. Para esta consulta, las coincidencias más cercanas son las páginas web que contienen contenido ofensivo y de odio. Hemos realizado un trabajo considerable para mejorar los casos en los que devolvemos contenido de baja calidad y continuaremos mejorando nuestros sistemas «.

Esta declaración es una reiteración de la respuesta inicial la empresa emitió a través de su cuenta de Twitter de enlace de búsqueda. En el hilo de Twitter, Google señaló los «vacíos de datos» (más sobre eso a continuación) como la razón por la que este contenido de odio puede aparecer en los resultados:

“Para los ‘cochecitos de bebé’, hay mucho contenido útil. Para esto, no lo hay. Eso no es sorprendente. No es probable que sea un tema que normalmente se busca, ni un producto real que se comercialice. Hay un «vacío» de buen contenido a la superficie que coincide con lo que se pidió … «

No hay planes para eliminar el contenido ofensivo. Google también ha dicho que no tiene una política de eliminación para este tipo de contenido y que está trabajando «para ver si hay otras formas de mostrar contenido más útil». Por supuesto, esta no es la primera vez que se detecta contenido controvertido y ofensivo en Google. En 2009, la compañía compró un anuncio de búsqueda para explicar por qué no estaba eliminando una imagen ofensiva de Michelle Obama, por ejemplo.

También nos hemos comunicado con Bing para obtener comentarios; sin embargo, no se recibió una respuesta al momento de la publicación. Actualizaremos este artículo si recibimos uno.

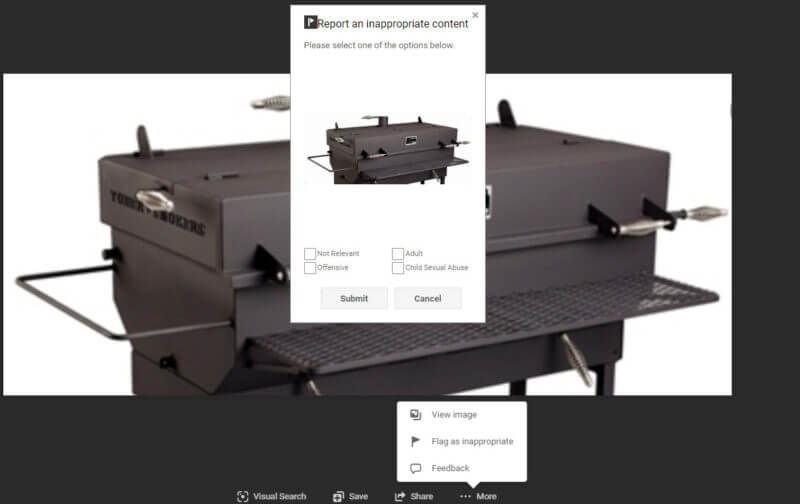

Informar imágenes ofensivas. En un momento dado, Google permitió a los usuarios informar imágenes ofensivas en sus resultados de imágenes. Esta característica ya no existe, al menos no en la forma en que lo hizo antes.

Ahora, los usuarios pueden enviar comentarios haciendo clic en una imagen en los resultados de la imagen y seleccionando «Enviar comentarios» en el menú de tres puntos en el panel de vista previa. A los usuarios se les presenta una ventana para resaltar el contenido sobre el que envían comentarios y un campo de texto para proporcionar más detalles.

Los usuarios pueden informar imágenes específicas en la búsqueda web de Google, pero esta funcionalidad solo está disponible cuando se muestran vistas previas de imágenes en la página principal de resultados de búsqueda y no hay opciones para proporcionar detalles sobre por qué se informa la imagen.

La funcionalidad de informes de imágenes de Bing es más sólida, lo que permite a los usuarios marcar una imagen como inapropiada marcando como motivo «No relevante», «Adulto», «Ofensivo» y / o «Abuso sexual infantil». Los usuarios que deseen dejar comentarios más específicos pueden hacerlo seleccionando «Comentarios», que proporciona una ventana emergente similar a la de Google.

¿Qué son los vacíos de datos?

Los vacíos de datos se refieren a términos de búsqueda para los cuales los datos relevantes disponibles son «limitados, inexistentes o profundamente problemáticos», según Michael Golebiewski y Danah Boyd de Microsoft en su informe. Vacíos de datos: donde los datos faltantes pueden explotarse fácilmente.

Los vacíos de datos son una consecuencia del diseño de los motores de búsqueda, afirma el informe. La suposición de que “para cualquier consulta determinada, existe algún contenido relevante”, es el meollo del problema. Cuando hay poco contenido disponible para devolver a los usuarios para un término de búsqueda en particular, como fue el caso de «cochecitos de bebé judíos», el contenido más relevante tiene un mayor potencial para que el contenido problemático y de baja calidad llegue a la cima.

¿Por qué los vacíos de datos son un problema?

Cuando hay poco contenido en competencia para una consulta, es más fácil conseguir que el contenido se clasifique para esa consulta. Cuando hay un vacío de datos, es aún más fácil para los actores maliciosos o de baja calidad hacerlo porque no están compitiendo con volúmenes de contenido de fuentes más confiables y / o relevantes.

No es realista pensar que el contenido apropiado siempre prevalecerá sobre el contenido de odio, especialmente para consultas problemáticas. «Sin la creación de contenido nuevo, existen ciertos vacíos de datos que no se pueden limpiar fácilmente», escribieron Golebiewski y Boyd, una noción que coincide con la afirmación de Google de que está evaluando otras formas de mostrar contenido más útil.

Cuando nadie está buscando estos términos, el problema puede pasar desapercibido, y un problema desapercibido a menudo es un problema inexistente en lo que respecta a la mayoría de las empresas responsables de solucionarlos. Sin embargo, cuando problemas como este captan la atención de los medios, el problema se agrava.

Caso en cuestión: al escribir sobre este tema en particular y presentar capturas de pantalla de los memes ofensivos, Google indexa esas instancias de imágenes, lo que aumenta la visibilidad de los memes antisemitas en los resultados de las imágenes (y por qué he optado por insertar tweets en lugar de capturas de pantalla de las propias imágenes ).

Las consultas problemáticas no son el único lugar donde existen vacíos de datos. En su reporte, Golebiewski y Boyd clasificaron los vacíos de datos en cinco categorías:

- Noticias de última hora: los usuarios pueden estar buscando términos relacionados con una historia de noticias de última hora antes de que esté disponible contenido preciso y de alta calidad al respecto.

- Nuevos términos estratégicos: la nueva terminología puede ser acuñada por actores malintencionados, y es posible que aún no exista contenido confiable relevante para esa terminología. Se dio el ejemplo de “actores de crisis”, refiriéndose a actores capacitados que hacen de víctimas simuladas; Los teóricos de la conspiración luego aplicaron estos términos al contenido sobre el tiroteo en la escuela primaria Sandy Hook de 2012 para difundir su falsa narrativa.

- Términos obsoletos: las palabras o frases que ya no se usan, como la terminología que ahora se considera racista, pueden no aparecer en el contenido publicado por fuentes acreditadas. Además, la estacionalidad (como las búsquedas de los Juegos Olímpicos de Invierno entre juegos) también puede resultar en un vacío de datos explotables.

- Conceptos fragmentados: los usuarios que buscan términos aparentemente sinónimos pueden obtener resultados completamente diferentes; por ejemplo, «extranjeros indocumentados» y «extranjeros ilegales». Si bien estos términos pueden converger con el tiempo, «los manipuladores de los medios también pueden explotar la resistencia de los motores de búsqueda a abordar las distinciones políticamente controvertidas para ayudar a fragmentar el conocimiento y la retórica».

- Consultas problemáticas: «cochecitos de bebé judíos», aunque no es un término intrínsecamente odioso, es un ejemplo de una consulta problemática. Esta categoría incluye consultas de búsqueda conspirativas y otras consultas impredecibles.

En cada uno de los escenarios anteriores, los vacíos de datos presentan a los actores malintencionados la oportunidad de utilizar algoritmos de motores de búsqueda para distraer y desinformar a los usuarios.

La respuesta de la comunidad de búsqueda

Numerosos profesionales de la búsqueda y el público en general a medida que esta historia comienza a atraer su atención, han instado a Google a tomar medidas más rápidas. En el tweet a continuación, Mordy Oberstein, enlace con la comunidad de SEO en Wix, señaló memes igualmente odiosos que aparecen para la consulta «literas judías».

Como sugirió Google en sus respuestas oficiales, la solución puede no ser tan simple como eliminar manualmente el contenido ofensivo del índice, una desafortunada realidad a la que aludió Victor Pan, jefe de SEO técnico de Hubspot, y ex Googler Pedro Dias.

Implicaciones de seguridad de la marca

Los sistemas de anuncios de Google no parecen estar monetizando estos resultados; no hemos visto anuncios en las páginas. Sin embargo, los memes ofensivos que se encuentran en la búsqueda de imágenes se encuentran en páginas web reales, y esas páginas web suelen llevar publicidad gráfica, mucha publicidad gráfica.

La captura de pantalla censurada a continuación es un ejemplo de una situación de la que muchos especialistas en marketing esperarían alejar a sus clientes: se vieron anuncios de Home Depot, Casper y un producto en Amazon junto con el contenido ofensivo. En este caso, los anuncios se publican a través de la red de orientación publicitaria basada en intereses de Amazon, no a través de la Red de Display de Google.

Navah Hopkins, director de medios pagados en Hennessey Digital, dijo que alentaría a sus clientes a reducir su inversión en Google Ads en el cuarto trimestre si Google no soluciona este problema.

«De donde proviene mi frustración y vacilación para alentar a las marcas a que continúen invirtiendo en las respectivas plataformas publicitarias es la renuencia a implementar salvaguardas contra estos malos actos, así como la negativa a eliminar el contenido de odio», dijo Hopkins a El Blog informatico: «Ya filtramos las ubicaciones que consideramos racistas y odiosas; si las redes publicitarias no pueden adoptar una postura sobre el contenido basado en el odio, tendremos que aplicar los mismos estándares».